【導讀】過去十年間,幾項技術的進步使人工智能 (AI)成為最令人振奮的技術之一。2012年,Geoffrey Everest Hinton在Imagenet挑戰(zhàn)賽中展示了他的廣義反向傳播神經(jīng)網(wǎng)絡算法,該算法使計算機視覺領域發(fā)生了革命性變化。然而,機器學習理論早在2012年之前就有人提出,并且Nvidia GTX 580圖形處理器單元等微處理器使這一理論得以實現(xiàn)。

過去十年間,幾項技術的進步使人工智能 (AI)成為最令人振奮的技術之一。2012年,Geoffrey Everest Hinton在Imagenet挑戰(zhàn)賽中展示了他的廣義反向傳播神經(jīng)網(wǎng)絡算法,該算法使計算機視覺領域發(fā)生了革命性變化。然而,機器學習理論早在2012年之前就有人提出,并且Nvidia GTX 580圖形處理器單元等微處理器使這一理論得以實現(xiàn)。這些處理器具有相對較高的內(nèi)存帶寬能力且擅長矩陣乘法,可將該神經(jīng)網(wǎng)絡模型的AI訓練時間縮短至大約一周。理論與算法的結合開啟了新一代技術進步,帶來了與AI相關的全新可能性。本文概述了人工智能設計新時代及其多樣化處理、內(nèi)存和連接需求。

人工智能剖析

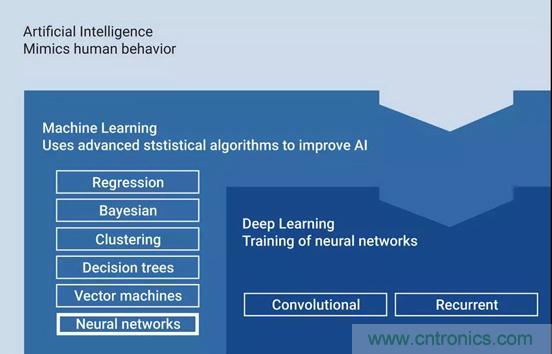

我們將神經(jīng)網(wǎng)絡定義為深度學習,它是機器學習及人工智能的一個子集,如圖1所示。這是一個重要的分類,深度學習該子集改變了芯片系統(tǒng)架構設計。

圖1:人工智能采用深度學習算法模仿人類行為

深度學習不僅改變了芯片架構,而且催生了半導體市場的新一輪投資。深度學習算法模型是研發(fā)和商業(yè)投資的熱點,例如卷積神經(jīng)網(wǎng)絡 (CNN)。CNN一直是機器視覺的主要焦點。遞歸神經(jīng)網(wǎng)絡等模型因其識別時間的能力而在自然語言理解中得以應用。

人工智能的應用

深度學習神經(jīng)網(wǎng)絡應用于許多不同的場景,為使用它們的人提供了強大的新工具。例如,它們可以支持高級安全威脅分析、預測和防止安全漏洞,并通過預測潛在買家的購物流程來幫助廣告商識別和精簡銷售流程。

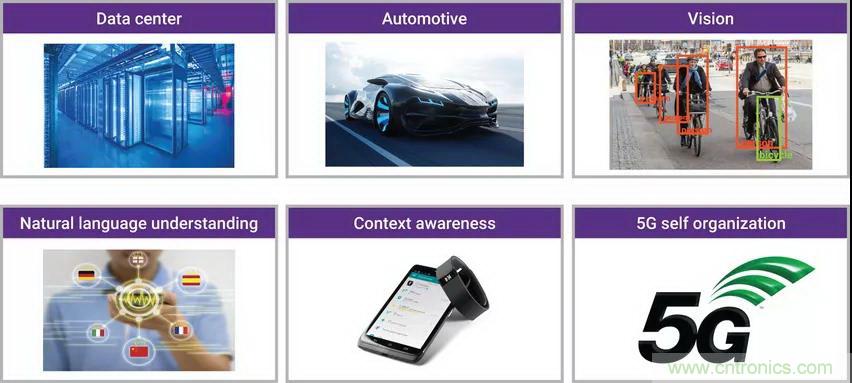

但AI設計并未局限于數(shù)據(jù)中心,諸如用于物件和人臉識別的視覺系統(tǒng)、用于改進人機接口的自然語言理解以及周圍環(huán)境感知等許多新功能可基于傳感器輸入的組合而使機器理解正在發(fā)生的活動。這些深度學習能力已融入到不同場景所需的芯片設計中,包括智能汽車、數(shù)字家庭、數(shù)據(jù)中心和物聯(lián)網(wǎng) (IoT),如圖2所示。

圖2:AI處理能力已結合到大量應用中

手機利用神經(jīng)網(wǎng)絡實現(xiàn)上述多種AI功能。手機可運行人臉識別應用、物件識別應用、自然語言理解應用。此外,它在內(nèi)部使用神經(jīng)網(wǎng)絡進行5G自組織,因為無線信號在其他介質、不同的光譜上會變得更密集,并且所傳輸?shù)臄?shù)據(jù)有不同的優(yōu)先級。

人類大腦

最近,深度學習通過數(shù)學和半導體硬件的進步變得可行。業(yè)界已開展多項舉措,在下一代數(shù)學模型和半導體架構中更好地復制人腦,這通常被稱為神經(jīng)形態(tài)計算。人類的大腦可以達到難以置信的高效率,但技術在復制人類大腦等方面才剛開始觸及皮毛。人類大腦包含超過1 PB (Petabyte=1024TB)的存儲空間,相當于大約540萬億個晶體管,且功率小于12瓦。從這點來說,復制大腦是一個長遠的目標。然而,ImageNet挑戰(zhàn)賽已從2012年的第一個反向傳播CNN算法發(fā)展到2015年更高級的AI模型ResNet 152,市場正在快速發(fā)展,新的算法層出不窮。

AI設計挑戰(zhàn)

融合深度學習能力的芯片架構促使了多項關鍵技術的進步,從而達到高度集成的解決方案和更通用的AI 芯片,包含專用處理需求、創(chuàng)新內(nèi)存架構和實時數(shù)據(jù)連接。

專用處理需求

融合神經(jīng)網(wǎng)絡能力的芯片必須同時適應異構和大規(guī)模并行矩陣乘法運算。異構組件需要標量、矢量DSP和神經(jīng)網(wǎng)絡算法能力。例如,機器視覺需要獨立的步驟,每一步都需要執(zhí)行不同類型的處理,如圖3所示。

圖3:神經(jīng)網(wǎng)絡能力需要獨特的處理

預處理需要更簡單的數(shù)據(jù)級并行性。對所選區(qū)域的精確處理需要更復雜的數(shù)據(jù)級并行性,可以通過具有良好矩陣乘法運算能力的專用CNN加速器有效地處理。決策階段通??梢酝ㄟ^標量處理的方式來處理。每個應用都是獨一無二的,但很明顯的是,包括神經(jīng)網(wǎng)絡算法加速的異構處理解決方案需要有效地處理AI模型。

創(chuàng)新內(nèi)存架構

AI模型使用大量內(nèi)存,這增加了芯片的成本。訓練神經(jīng)網(wǎng)絡要求達到幾GB甚至10GB的數(shù)據(jù),這就需要使用DDR最新技術,以滿足容量要求,例如,作為圖像神經(jīng)網(wǎng)絡的VGG-16在訓練時需要大約9GB的內(nèi)存;更精確的模型VGG-512需要89GB的數(shù)據(jù)才能進行訓練。為了提高AI模型的準確性,數(shù)據(jù)科學家使用了更大的數(shù)據(jù)集。同樣,這會增加訓練模型所需的時間或增加解決方案的內(nèi)存需求。由于需要大規(guī)模并行矩陣乘法運算以及模型的大小和所需系數(shù)的數(shù)量,這就要求配備具有高帶寬存取能力的外部存儲器及新的半導體接口IP,如高帶寬存儲器 (HBM2)和衍生產(chǎn)品 (HBM2e)。先進的FinFET技術支持更大的芯片SRAM陣列和獨特的配置,具有定制的存儲器到處理器和存儲器到存儲器接口,這些技術正在開發(fā)中,為了更好地復制人腦并消除存儲器的約束。

AI模型可以壓縮,確保模型在位于手機、汽車和物聯(lián)網(wǎng)應用邊緣的芯片中受限的存儲器架構上運行所必需的。壓縮采用剪枝和量化技術進行且不能降低結果的準確性,這就要求傳統(tǒng)芯片架構(具有LPDDR或在某些情況下沒有外部存儲器)支持神經(jīng)網(wǎng)絡。隨著這些模型的壓縮,不規(guī)則的存儲器存取和計算強度增加,延長了系統(tǒng)的執(zhí)行時間。因此,系統(tǒng)設計人員正在開發(fā)創(chuàng)新的異構存儲器架構。

實時數(shù)據(jù)連接

一旦AI模型經(jīng)過訓練并可能被壓縮,就可以通過許多不同的接口IP解決方案執(zhí)行實時數(shù)據(jù)。例如,視覺應用由CMOS圖像傳感器支持,并通過MIPI攝像頭串行接口 (CSI-2)和MIPI D-PHY IP連接。LiDAR和雷達可通過多種技術支持,包括PCI Express和MIPI。麥克風通過USB、脈沖密度調制 (PDM) 和I2S等連接傳輸語音數(shù)據(jù)。數(shù)字電視支持HDMI和DisplayPort連接,以傳輸視頻內(nèi)容,而這些內(nèi)容可通過神經(jīng)網(wǎng)絡傳輸后得到改善,實現(xiàn)超高圖像分辨率,從而以更少的數(shù)據(jù)生成更高質量的圖像。目前,大多數(shù)電視制造商正在考慮部署這項技術。

混合AI系統(tǒng)是另一個預計會大量采用的概念。例如,心率算法通過健身帶上的AI系統(tǒng)可以識別異常,通過將信息發(fā)送到云端,對異常進行更準確的深入AI神經(jīng)網(wǎng)絡分析,并加以提示。這類技術已經(jīng)成功地應用于電網(wǎng)負載的平衡,特別是在電線中斷或出現(xiàn)意外重負荷的情況下。為了支持快速、可靠的網(wǎng)絡與云端連接,上述示例中的聚合器需要以太網(wǎng)連接。

消除瓶頸

盡管復制人類大腦還有很長的路要走,但人類大腦已被用作構建人工智能系統(tǒng)的有效模型,并繼續(xù)由全球領先的研究機構來建模。最新的神經(jīng)網(wǎng)絡試圖復制效率和計算能力,芯片架構也開始通過緊密耦合處理器和內(nèi)存來復制人類大腦。ARC子系統(tǒng)包括AI及其APEX擴展和普遍存在的RISC架構所需的處理能力。子系統(tǒng)將外設和存儲器緊密耦合到處理器,以消除關鍵的存儲器瓶頸問題。

用于AI的DesignWare IP

AI是最令人振奮的技術之一,特別是深度學習神經(jīng)網(wǎng)絡,通過結合神經(jīng)網(wǎng)絡算法的創(chuàng)新以及高帶寬、高性能半導體設計的創(chuàng)新而飛速發(fā)展。

新思科技正在與世界各地細分市場中領先的AI 芯片供應商合作,提供采用經(jīng)過驗證的可靠IP解決方案,幫助他們降低芯片設計風險,加快產(chǎn)品上市速度,并為AI設計人員帶來關鍵的差異化優(yōu)勢。

專用處理需求、創(chuàng)新內(nèi)存架構和實時數(shù)據(jù)連接構成了人工智能芯片的DNA,面對AI設計挑戰(zhàn),新思科技提供了許多專業(yè)處理解決方案來消除存儲器瓶頸,包括存儲器接口IP、帶有TCAM和多端口存儲器的芯片SRAM編譯器等,同時提供了全面的實時數(shù)據(jù)連接選項。這些IP解決方案是下一代AI設計的關鍵組件。