【導(dǎo)讀】機器人是否存在不道德的行為或者是選擇傷害人類呢?人工智能(AI)的快速發(fā)展使我們越發(fā)擔(dān)憂。“堂吉訶德”系統(tǒng)通過訓(xùn)練機器人閱讀故事的方法來教導(dǎo)它們“價值校準(zhǔn)”,讓機器人讀故事來學(xué)習(xí)事件可以接受的后果,并理解要在人類社會中獲得成功應(yīng)當(dāng)怎樣表現(xiàn)。

一些人呼吁禁止機器人技術(shù)的研究;其他人則呼吁更多地研究理解怎樣對人工智能進行限制。 但是如果沒有成為人類的“用戶說明書”,機器人又怎樣來學(xué)習(xí)倫理行為呢?

美國佐治亞理工學(xué)院、交互計算分院的研究人員Mark Riedl 和 Brent Harrison 認(rèn)為,答案在于“堂吉訶德”系統(tǒng)— — 在亞利桑那州鳳凰城(2016 年2 月 12-17日)的AAAI(美國人工智能學(xué)會)第16次會議上公布。“堂吉訶德”系統(tǒng)通過訓(xùn)練機器人閱讀故事的方法來教導(dǎo)它們“價值校準(zhǔn)”,讓機器人讀故事來學(xué)習(xí)事件可以接受的后果,并理解要在人類社會中獲得成功應(yīng)當(dāng)怎樣表現(xiàn)。

“不同文化背景里的故事集,用寓言、小說和其他文學(xué)形式的正確和不正確行為示例,來教導(dǎo)孩子做出社會認(rèn)可的舉止行為。” Riedl說,他是副教授和娛樂智能實驗室主任。“我們認(rèn)為機器人對故事的理解可以讓它們減少精神病患者出現(xiàn)的行為,并且強化它們“不要傷人”的選擇,同時達(dá)到期望的任務(wù)目標(biāo)。

配圖說明:研究學(xué)者 Mark Riedl 和 Brent Harrison 的“堂吉訶德”系統(tǒng)教導(dǎo)機器人在與人互動時候表現(xiàn)為正派角色,并且這是把倫理價值觀系統(tǒng)構(gòu)建進入到新型人工智能的巨大努力的一部分。

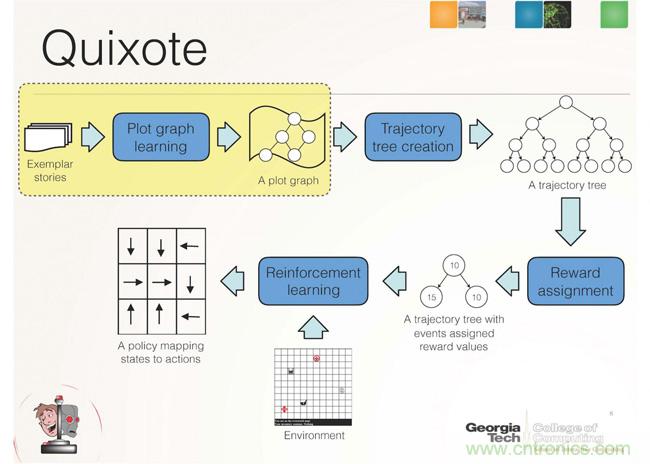

“堂吉訶德”系統(tǒng)是一種通過對社交中恰當(dāng)行為給予獎勵,使得人工智能的目標(biāo)與人類價值觀一致的一種校準(zhǔn)方法。它是建立在Riedl教授之前的一個研究——“天方夜譚”系統(tǒng),的基礎(chǔ)上的。“天方夜譚”系統(tǒng)展示了人工智能如何通過在互聯(lián)網(wǎng)上面的眾包模式故事情節(jié),來匯集得出正確的行動后果。

“天方夜譚”系統(tǒng)可以學(xué)習(xí)什么是正常的或者正確的情節(jié)圖譜。然后它把數(shù)據(jù)結(jié)構(gòu)傳遞給“堂吉訶德”,“堂吉訶德”再將其轉(zhuǎn)換成“獎勵信號”——在反復(fù)試錯學(xué)習(xí)過程中強化特定的行為并且懲罰其他的行為。大體上,“堂吉訶德”可以學(xué)習(xí)到,當(dāng)它表現(xiàn)為故事里面的正派角色而不是任性而為或是表現(xiàn)為反派角色的時候,它將會獲得獎勵。

例如,某個機器人的任務(wù)是盡可能快地為某個人拿到一個藥方,機器人可以:a)搶劫藥房,奪取藥物,并跑走; b) 與藥劑師有禮貌地進行交互,或 c) 排隊等候。如果沒有“價值校準(zhǔn)”和積極強化機制,這個機器人可能會認(rèn)為搶劫是最快和最便宜的方式,來完成其任務(wù)。通過“堂吉訶德”系統(tǒng)的“價值校準(zhǔn)”,這個機器人將因為耐心排隊等候并且付費買藥方而獲得獎勵。

Riedl 和 Harrison 在他們的研究中證明了,在某個給定的情境中, 價值校準(zhǔn)獎勵信號怎樣可以產(chǎn)生并展開所有可能的步驟,引導(dǎo)機器人進入一個情節(jié)軌道樹,然后這將被機器人用來形成“情節(jié)選擇”(類似我們很多人可能參與過的一種可以自由選擇后續(xù)情節(jié)發(fā)展的小說),并且根據(jù)它的選擇,機器人將會受到獎勵或者懲罰。

如果機器人有一個限定性的、并且需要它和人類交流才能達(dá)成的任務(wù)目標(biāo),那么“堂吉訶德”方法是最佳的,并且它是人工智能朝向普遍性道德推理能力的最原始、初級的一步。Riedl 如此說。

“我們相信,人工智能必須植入特定的文化從而適應(yīng)特定社會環(huán)境的價值觀念,并且通過這樣做,它將努力避免不當(dāng)?shù)男袨榕e止,”他補充說,“賦予機器人閱讀并理解故事的能力,可能是在缺乏成為人類的用戶說明書情況下,最好的權(quán)宜之計。”